Robotikk og moral

I laboratorier verden over forskes det fram nye teknologiske løsninger, som rykker robotene sakte men sikkert nærmere menneskelig intelligens. Veien mot målet er full av hindringer, men når vi kommer dit – er vi klare for å hilse maskinene velkommen?

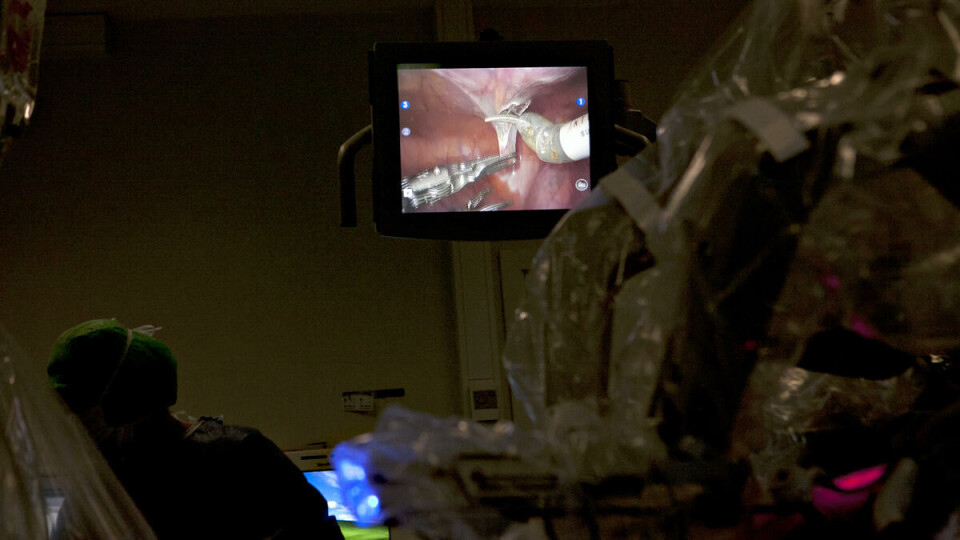

En svær, hvit-grå maskin med edderkoppaktige armer tårner over en til sammenligning bitteliten menneskekropp. Kroppen er dekket i grønt og plast på operasjonsbordet på urologisk avdeling på Aker sykehus. Det er tøvær ute. Inne småprater sykepleiere og kirurger med hverandre, mens de fikler med menneske og maskin og ber oss sette oss pent ned så vi ikke besvimer. Kirurg Victor Berge trøkker metallstaker inn i magen på syttiåringen, som skal opereres for prostatakreft, mens operasjonssykepleiere passer på at gigantedderkoppen ikke krasjer i pasientens slappe armer og bein. Det hele ser nesten brutalt ut, men pasienten er i de beste hender.

Denne morgenen skal prostataen ut gjennom pasientens navle, og det er den robotiske «Da Vinci»-maskinen som skal stå for kutting, brenning, sying og saksing før kirurgene kan fiske den ut. Berge setter seg godt til rette i en konsoll i hjørnet av rommet og griper joystickene foran seg. To menneskeføtter i grønne sokker plasseres på et sett av fire pedaler, mens matchende, grønne crocs settes pent til side.

– Er vi klare? Berges stemme lyder over en høyttaler ut i rommet.

På en stor skjerm bak pasienten dukker et ti ganger forstørret bilde av innsiden av buken opp. Berges kirurgkollega, Jon-Roar Fosse, assisterer under operasjonen og passer på at alt går som det skal borte ved pasienten. Han er mildt sagt optimistisk på vegne av bruken av robotikk-hjelpemidler til kirurgiske inngrep, og prater villig i vei mens Berge og roboten gjør seg klare.

– Før brukte vi manuell laparoskopi, kikkhullsoperasjoner med stive metallinstrumenter som vi manøvrerte selv. Når vi bruker «Da Vinci» er det som å sitte inne i kroppen til pasienten. Om 15-20 år, tror jeg vi bare vil bruke robotassistert kirurgi på denne type operasjoner.

Mens Fosse skryter av sin metalliske venn, er Berge og «Da Vinci»-maskinen i ferd med å skride til verket. Sammen skal de sørge for at pasienten blir kvitt kreften. Men hvordan i all verden kom dette hyperteknologiske samarbeidet mellom menneske og maskin i stand? Svaret er robotikk.

Et par uker tidligere sitter en blåøyd, for ikke å snakke om vettskremt, journalist inne i et laboratorium på Institutt for informatikk (IFI) på Universitetet i Oslo. Vi har nettopp hørt forskningsgruppene på IFI fortelle om arbeidet sitt. Mellom utgreiinger på nerdenes stammespråk om dopa silisium, integrerte kretser, millioner av nanometerstore transistorer, Moores lov og gudene vet hva, har vi fanget opp at det ikke er lenge til datamaskinene er like intelligente som mennesker.

Mellom oss og instituttleder for robotikk og intelligente systemer, Jim Tørresen, ligger en edderkopprobot i noe mindre størrelsesorden enn gigantroboten på Aker. Den er ikke større enn en halvmeter i diameter, omtrent som en fjernstyrt lekebil. Tørresen forklarer i vei så ivrig at han snubler i ordene. Det er tydelig at han gjerne vil vi skal forstå. Da Vinci-maskinens teknologi er nemlig bare barnemat i forhold til hva de forsker på her. De skal lære robotene å tenke selv, ikke bare adlyde kommandoen til en kirurg.

– Intelligent evolusjon handler om å programmere roboter til å lære av sine egne feil. De er som barn i starten, de har lite lagret informasjon. Hos mennesker bygges informasjonen opp gradvis gjennom prøving og feiling. Vi lar maskinen finne en bedre løsning gjennom interaksjon med omgivelsene, for eksempel for å finne et effektivt gåmønster. Den prøver et hopetall av løsninger, for så å forkaste de dårlige og bevare de beste.

Tørresen forklarer og suppleres av overingeniør Yngvar Hafting, som viser oss inn i et nedstrippa, teppebelagt rom med noe som ser ut som overvåkningskameraer i alle hjørner. En datamaskin står og durer i et hjørne. Dette er treningsstudioet til edderkoppen, hvor den øver seg på å gå, eller datamaskinen øver seg på å simulere at roboten går.

– Edderkopprobotens bevegelse kan også simuleres inni en datamaskin, forklarer Hafting.

– Markørene som er festet på roboten fanges opp av infrarødt lys i kameraene, som dermed kan fange opp hvor roboten befinner seg i rommet. Utfordringen er å lage simuleringen mest mulig lik bevegelsen til den virkelige roboten.

Simulering, gåmønstre og edderkopproboter. Hva har alt dette med fremtidens robotikk å gjøre?

– Poenget med dette er at vi vet at en robot kan kopiere bevegelser, men målet er å få den til å gjøre noe den ikke har gjort før – på egenhånd, sier Tørresen.

Akkurat nå snakker vi om leketøylignende roboter, men hvis de knekker denne intelligenskoden – kan da godeste «Da-Vinci» erstattes med en sjøldreven R2D2 med verktøyene i egne hender? Det er nok ikke riktig så lett.

Gutta på IFI driver med grunnforskning, «Proof of concept», som Hafting kaller det. Det forskes samtidig i mange land, i mange forskningsgrupper som alle konsentrerer seg om å løse små hindre på veien.

– Verktøyene vi lager gjør det i hvert fall mulig å prøve å få til en overgang fra teori til virkelighet, svarer Hafting på skuffede hint om at dette ikke svarer til våre forventninger om en robotrevolusjon.

Vi må vekk fra teoriene og finne de som prøver å sette dem ut i live. Med et lite håp om at de kanskje snakker noe som nærmer seg norsk for oss teknisk inkompetente, roter vi oss langt inn i Rikshospitalets sykehushvite irrganger. I en liten avdeling bestående av trange, papirnedlessede kontorer, pappesker og duppeditter, finner vi Innovasjonssenteret. Seksjonsleder innen teknologisk forskning på Oslo Universitetssykehus, Ole Jakob Elle, forklarer hvordan vi ligger an på teknologifronten innen robotisk kirurgi.

Han starter der kirurg Fosse slapp, med «Da Vinci» og dens fordeler, hvordan den ble utviklet i USA for å kunne utføre fjernkirurgi under Gulfkrigen, og siden den gang har økt kirurgens presisjon og pasientens restitusjonstid. Elle legger imidlertid til at det tekniske vidunderet har sine begrensninger.

– «Da Vinci» er vanskelig å manøvrere, og er dessuten et stort, dyrt system, som koster opp mot 22 millioner kroner. Den er også i utgangspunktet ganske dum, den kan ikke skalere bevegelser etter hvor mye kraft som trengs, eller kjenne berøring. Kirurgen må kun lene seg på visuell feedback.

Ikke at forskerne har tenkt til å gi seg med dét. Elle har tatt med seg Phd-kandidaten Kim Mathiassen, som er del i et stort samarbeidsprosjekt mellom over tyve EU-land, kalt Intelligent Surgical Robots (I-SUR). Mathiassen er en sjenert, ung fyr med store ambisjoner: Prosjektet han er en del av, prøver å løse nettopp den lille haken ved robotisk kirurgi som Elle nevnte: At maskinen ikke kan kjenne om den tar for hardt i.

Mathiassen og gjengen i I-SUR prøver å få roboten til å stikke en nål inn til et mål inne i kroppen. De har introdusert kraftsensorer som kan måle styrken nålen stikkes inn med. Kameraene som er stukket inn i huden på metallpinner, er som øyne som også kan oppfatte dybde i bildet, og dermed se hvor langt nåla er fra der den ble stukket inn. Sleng på noen små baller som festes på nålene som kan følges via «optisk tracking», og vi kan følge med på hvor nåltuppen er fra utsiden. Voilà.

Elle og Mathiassen forklarer, vi nikker og later som vi forstår. Kompliserte greier, dette. Kim ser de flakkende blikkene våre og prøver å presisere hva i huleste det er han driver på med.

– Vi stikker inn en nål, ikke sant? Ultralyden ser hvor nåla er etter at den har trengt inn gjennom huden. På datamaskinen analyseres ultralydbildet hele tiden for å finne hva slags vinkel tuppen på nåla står i og hvor den er i forhold til målet. Vi bruker en evolusjonær algoritme til å optimalisere parametrene til programmet som finner nålen.

Det er «baby steps» og én ting av gangen over hele fjøla. Her kommer de mystiske algoritmene inn igjen, de som Tørresen snakket om på IFI. De er visst det store aberet for å få maskinene til å tenke sjæl. Ikke bare skal legene være i stand til å gå fra kikkhulls- til nålehullskirurgi med innbakt «følelse i fingrene», på toppen av det hele skal Mr Metallic gjøre det hele på egenhånd.

– Vi prøver å utvikle sansene til roboten ved hjelp av disse evolusjonære algoritmene, som en slags «survival of the fittest». Vi gir programmet et sett gode og dårlige kandidater eller parametre, dataen tester dem ut, rangerer dem og kaster ut de dårlige. De beste parer seg og testes på nytt, så gjentas dette veldig mange generasjoner på rad. På en data tar dette et kvarters tid, i naturen tar det mange generasjoner, forklarer Mathiassen.

Denne teknologien kommer ikke til å bli tatt i bruk i morgen og ikke i overmorgen heller. Det er som om forskerne vi snakker med, går stille i dørene, dysser ned forventningene til det som uunngåelig kommer en gang i framtiden. De er en liten klan av opplyste som ikke lager så mye oppstuss rundt seg. Hvis de hadde gjort det, ville vi nok uansett ikke forstått hva de prøvde å fortelle oss. De som har peiling på dette, revolusjonerer teknologien sakte, men sikkert i forskningsgrupper over hele verden.

En ting er at robotene vil kunne bli i stand til å tenke selv. Et annet spørsmål er hva som skjer når mekanikken og elektronikken kobles direkte til menneskene i form av proteser og forlengelser av kroppen.

Tilbake på IFI har Hafting og Tørresen fått selskap av Mats Høvin, førsteamanuensis i robotikk og intelligente systemer. Han har laget en metallhånd som ser mistenkelig ut som noe vi har sett på film, for å forske på bruken av kunstige muskelfibre. Disse skal kunne erstatte motorene som brukes i dagens elektroniske proteser, for å fjerne vekt og ikke minst bråk. Men hva er det som hindrer oss i å koble metallhånda på en armstump og få den til å lystre hjernens befalinger om hvordan den skal oppføre seg? Høvin ser nærmest oppgitt på oss. Det er ikke så enkelt, nei. Han legger ut på avslepen nordlandsdialekt.

– For å kunne føle med en protese, må du ha kontakt mellom sensorene på fingertuppene som kan føle varme, trykk og berøring og kanalene som sender informasjonen tilbake til hjernen, forklarer han.

– Første gang du tar på en protese med denne typen teknologi vil det føles helt galt, men på grunn av plastisiteten i nervesystemet vil man venne seg til de nye følelsene når hjernen kobler om og tilpasser seg.

Plastisitet vil si at hjernen kan koble om nerver som har blitt koblet sammen feil. Planen er å overføre hjernens evne til å koble om, til teknologien.

– Nerver som kuttes av, for eksempel ved en amputasjon, vil vokse sammen av seg selv hvis nervestumpene blir satt sammen. Vi forsøker å plassere noe som heter sil-elektroder under huden mellom to nervestumper. Når disse gror sammen gjennom elektroden, vil elektroden gro inn i nerven. Denne kan avlese impulsene som kommer ut, og sende impulser tilbake selv, uten å bruke hjernens plastisitet.

Tanken er at elektronikken selv vil kunne sende beskjeder tilbake til hjernen, med tilbakemelding fra hva protesen føler i omgivelsene.

Enn så lenge brukes mer primitive proteser med åpne- og lukkemekanismer, som en klype. Den kan gripe en kopp og helle innholdet inn i for eksempel en munn, men kan altså ikke føle noe som helst. Forskerne jobber på spreng for å forbedre bevegelsesmulighet og følsomhet.

– Andre forskningsgrupper jobber med å kunne avlese nervetråder, som i fremtiden kan brukes sammen med kunstige muskelfibre. Det er små hindre hele veien som forskere ønsker å løse. Vi jobber med kunstige muskler og utvikler kunstig evolusjon, men det er ikke direkte koblet til mennesker – ennå, kommenterer Hafting fra sidelinja.

Problemet består i at kroppen ikke vil snakke med elektronikken. Dette er det store hinderet før vi kan nærme oss uekte lemmer på linje med Petter Pittelpytts magiske hånd i Harry Potter. En av disse «andre» som forsker på avlesning av nervetråder, er Øyvind Stavdahl, førsteamanuensis i medisinsk robotikk ved NTNU.

Vi møter ham i en hotellbar omgitt av businessmenn i stive dresser og slips, hvor han selv sitter i jeans og hettegenser og snakker bedagelig om at han pleier å si at fremtiden allerede er her. Businessmennene sniklytter nysgjerrig, men Stavdahl enser dem ikke. Det han sikter til er robotiske gressklippere og støvsugere, eller industriroboter som løfter, flytter og spraylakkerer. Det er bare det at de ikke ser ut som mennesker.

– Når det er snakk om robotikk, ser du for deg Robocop, Luke Skywalker og Darth Vader – Science fiction-bilder fra Hollywood – men verden har ikke kommet så langt som Hollywood. Det er nærliggende å tenke at roboter skal ligne på mennesker, men det trenger de ikke. Ta for eksempel løfteroboter i eldreomsorgen. Jeg ville ikke lagt meg i armene på en robot som sto på to bein, fordi de er mye mer stødige på fire hjul.

Ifølge Stavdahl har forskerne ingen problemer med å lage kroppsdeler som er sterkere, raskere og som tåler mer enn en menneskekropp, men kommunikasjonsproblemene mellom kroppen og kunstige kroppsdeler gjør at det er som å ha en kjemperask bil med svarte ruter og uten ratt.

– De bevegelige protesene vi har i dag, har en motor som er koblet til en bitteliten datamaskin som lytter til kroppens signalsystem, men det er vanskelig å høre forskjell på signalene, for eksempel beskjeder om å bevege ulike fingre. Derfor er dagens robotproteser veldig enkle. De kan «høre forskjell» på signalene som beordrer bevegelse den ene eller andre veien, men gjerne bare i ni av ti tilfeller.

At elektronikken ikke bestandig fungerer, gjør at mange velger å bruke enklere hjelpemidler, for å slippe å miste kaffekoppen i gulvet den tidende gangen, da elektronikken «leser» kroppens signaler feil. Å løfte proteseteknologien til det neste nivået krever teknologi som per i dag ikke finnes. Stavdahl peker på armen sin, tegner og forklarer.

– Nervene er ledninger fra hjernen som styrer bevegelser. Men si at det er 50 000 nervetråder i en nervebunt, hvor noen sender signaler ut og andre tar inn tilbakemeldinger. Hver nervetråd er maks en mikrometer stor, og vi vet ikke hvordan vi skal kunne måle hvilke som sender info ut og inn.

Enn så lenge foretas målingen fra utsiden av huden – signaler på oversiden av armen forteller protesen at den skal bøye seg opp, og signaler på undersiden kommanderer bevegelse nedover. Stavdahl og kompani vil inn under huden for å gjøre mer nøyaktige målinger. Problemet er bare at signalene nervene sender frem og tilbake utgjør et kjempestort hylekor.

– Hvis vi prøver å feste elektroder rundt de forskjellige nervebuntene, blir det som å prøve å måle 50 000 telefonsamtaler på én gang. Å skille én samtale fra en annen er mildt sagt vanskelig, sier Stavdahl.

Selv om kroppen ikke vil snakke med robotikken, har møtet mellom menneske og robotikk meldt sin tilstedeværelse i helse- og omsorgssektoren. Et raskt google-søk avslører et lass med bilder av roboter fra Japan. Omsorgsroboter til flytting og løfting av sengeliggende eldre, selunger som kan underholde eldre på sykehjem, og hule skjeletter som kan lære kroppen å gå igjen etter skader. Amerikanerne utvikler høyteknologisk rehabiliteringsutstyr raskere enn du kan si NASA. Hva er det de har, som ikke vi har?

– I USA er det en rekke militærsponsede forskningsprosjekter hvor det jobbes med å utvikle gode hjelpemidler innen rehabilitering som er litt mer i retning robocop. Der testes det ut avansert utstyr med mange motorer, men det er ikke kommersielt modent ennå. Japan på sin side har kommet lengst, fordi de har størst behov for helsearbeidere med en allerede overhengende eldrebølge, sier Stavdahl.

Teknologien utvikles etter behov og ressurser: Helsevesenet kommer til å etterspørre lignende løsninger også i Norge. At forskerne kommer til å overskride problemstillingene robotikken står overfor i dag, mener Stavdahl er et spørsmål om «når», ikke «hvis».

– Fremtiden holder ingen grenser for humanoide roboter. Vi har ingen mulighet til å forestille oss hva teknologien kan gjøre. Noen kommer til å løse problemet med kunstig intelligens og klare å forlenge nervesystemet til elektronikken, det er bare et spørsmål om tid.

Vi ramler overveldet ut av robotikkens verden. Herre fred. Hvis forskerne har rett, og robotene kommer – om ikke i morgen så om hundre, sågar fem hundre år, er det nødt til å skape et drøss med etiske og juridiske problemstillinger. Professor i medisinsk etikk, Bjørn Morten Hofmann, er en tenker av den gamle skolen: En etiker som er i stand til å se for seg hypotetiske scenarioer uten å frykt for å bli tatt for faktafeil. Han mener de største etiske utfordringene vi kommer til å støte på, er der hvor robotene brukes for å erstatte menneskelig kontakt.

– La oss bruke helse og omsorg som eksempel. Robotselen Paro som er utviklet i Japan, er sosialt og emosjonelt stimulerende, men når den brukes til å erstatte menneskelig kontakt går vi mot et fattigere samfunn. Det er fortsatt forskjell på oss og maskiner. I vår kultur består menneskelig kontakt i noe genuint, det utfyller ikke bare en funksjon.

Hvis robotene skal utføre kirurgiske inngrep, vil det dessuten være et spørsmål om hvem som har ansvaret når noe går galt. Hvem har ansvaret hvis en robot gjør et feilskjær under en operasjon? Sykehuset som har kjøpt maskinen? Kirurgen med ansvaret for operasjonen? Skyldes bommerten produsenten og dårlig programvare?

– Det vil oppstå en lang rekke tvilstilfeller som må løses moralsk og juridisk, men det kan oppstå så mange uklare tilfeller at jussen ikke strekker til, sier Hoffmann og legger til:

– Å regulere komplekse og dynamiske forhold juridisk er vanskelig nok allerede. Når maskiner i tillegg blir autonome og kan ta faglige beslutninger selv, vokser denne gråsonen veldig mye.

Hofmann mener vi er flinkere til å utvikle teknologien enn til å overskue de moralske og juridiske konsekvensene: Vi har blitt teknologiske kjemper og etiske pygmeer.

Hva gjør vi når maskiner blir aktører og moralske subjekter? Skal vi tillegge dem ansvar? Skal de sperres i fengsel i form av lavstrømsanstalter når de gjør noe galt?

– Hva gjør vi når maskiner blir aktører og moralske subjekter? Skal vi tillegge dem ansvar? Skal de sperres i fengsel i form av lavstrømsanstalter når de gjør noe galt? Utfordringen består i at ansvar knyttes til personer – vesener som har selvrefleksjon, kan forme intensjoner og handle i tråd med sine egne valg, som forstår sosiale settinger. Vi har ingen garanti for at robotene kommer å utvikle disse ferdighetene.

Hofmann mener også at forskerne må ta sin del av ansvaret for eventuelle konsekvenser av teknologien de selv er med på å utvikle. Han deler ansvaret inn i to typer: ansvar for at forskningen ikke umiddelbart skader folk eller utsletter liv på jorden, og ansvar for å informere og reflektere over mulig misbruk av teknologien.

– Når forskningsresultater tolkes feil og blåses opp i media, kan du ikke si at du ikke har noe med det å gjøre. Da underkjenner du ansvaret du har som forsker. Forskere får penger for å være ekspert på et område, de kan ikke skru av det ansvaret. Forskerne selv er de beste til å overskue og reflektere over hva forskningen kan brukes til. Det vil alltid være utilsiktede konsekvenser knyttet til ny teknologi, men det er forskerne som er best egnet til å forutse disse.

Mens forskerne står overfor tilsynelatende uoverkommelige teknologiske og etiske utfordringer, durer den eksisterende robotteknologien i vei hver eneste dag. Tilbake på Aker sykehus er operasjonen godt i gang. Berge instruerer sykepleiere og medkirurg Fosse, som passer på at kameravinklene er som de skal.

– Litt nærmere der, ja, sier Berge når sykepleieren skal feste klips for å passe på at ereksjonsnerven ikke blir skadet.

På disse ømfintlige områdene må de klippe i stedet for å brenne. «Da Vinci» fikser den biffen mens morbide bilder av brent vev og piplende blod roper om oppmerksomhet fra skjermen. Menneskemagen er blåst opp for å gi kirurgen tumleplass der inne. Vi står med åpen munn og glaner, selv om det er på grensen til kvalmende.

Når prostata er lirket løs, legges den igjen i buken mens de bytter robotens håndledd fra metallklypene som brant bort vev og kuttet løs prostata, til sy-instrumenter. De små «hendene» syr urinrøret sammen med urinblæra med raske, nennsomme bevegelser.

Det hele har tatt en time-halvannen, og nå kan kirurgene Berge og Hoff nappe prostata ut og sy igjen de små hullene i pasientens mage. Det så lett ut, men bak ligger flere års trening på samhandlingen mellom kirurg og maskin. Robotikk er fremtiden, men kirurgene frykter ikke at jobben deres vil bli overtatt av roboter med det første, selv om det i første øyekast kunne virke behagelig, skal vi tro Hoff.

– Om femti år kan kanskje kirurgen sitte der i en stressless med kaffekoppen i hånda, og se på mens roboter utfører operasjonen. Kanskje med en stoppknapp for å gripe inn hvis noe går galt. Men det må ikke bli for automatisert – da har ikke kirurgene noen jobb lenger. Det vil nok ikke det kirurgiske miljøet være med på, sier han mens roboten skrus av for denne gang.